[ 소개 ] Data Engineering 마스터를 위한 7개의 프로젝트

구독하고있던 KDnuggets에서 오랜만에 눈에 띄는 아티클을 봤다.

이런 아티클들이 지금까지 몇 있었지만 다음에 봐야지 하고 넘겼다가 잊혀지는 경우가 많았다.

그래서 나중에 내가 필요할 때라도 다시 찾아보기 쉽게 이 아티클의 소개 글을 써두기로 했다.

소개하고 있는 7개 프로젝트의 이름은 다음과 같다.

1. Data Engineering ZoomCamp

2. Stream Events Generated from a Music Streaming Service

3. Reddit Data Pipeline Engineering

4. GoodReads Data Pipeline

5. End-to-end Uber Data engineering project with BigQuery

6. Data Pipeline for RSS Feed

7. YouTube Analysis

[ Data Engineering ZoomCamp ]

- Repository Link -

data-engineering-zoomcamp/projects at main · DataTalksClub/data-engineering-zoomcamp

Free Data Engineering course! . Contribute to DataTalksClub/data-engineering-zoomcamp development by creating an account on GitHub.

github.com

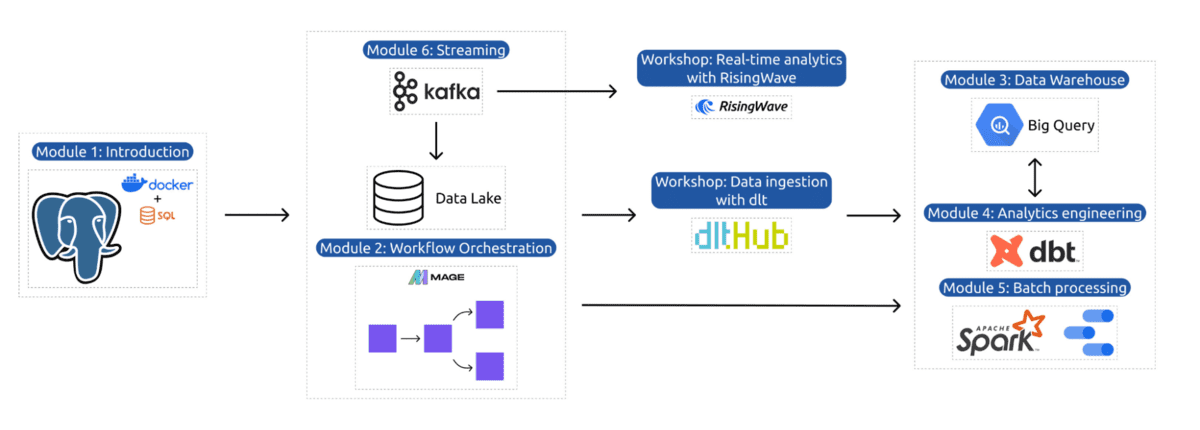

Data Engineering ZoomCamp는 DataTalksClub에서 제공하는 9주 과정의 무료 강좌다.

이 프로젝트에는 데이터를 처리하기 위한 파이프라인 생성, 데이터 레이크에서 데이터 웨어하우스로의 데이터 이동, 데이터 변환, 그리고 데이터를 시각화하기 위한 대시보드 구축이 포함되어있다.

[ Stream Events Generated from a Music Streaming Service ]

- Repository Link -

GitHub - ankurchavda/streamify: A data engineering project with Kafka, Spark Streaming, dbt, Docker, Airflow, Terraform, GCP and

A data engineering project with Kafka, Spark Streaming, dbt, Docker, Airflow, Terraform, GCP and much more! - ankurchavda/streamify

github.com

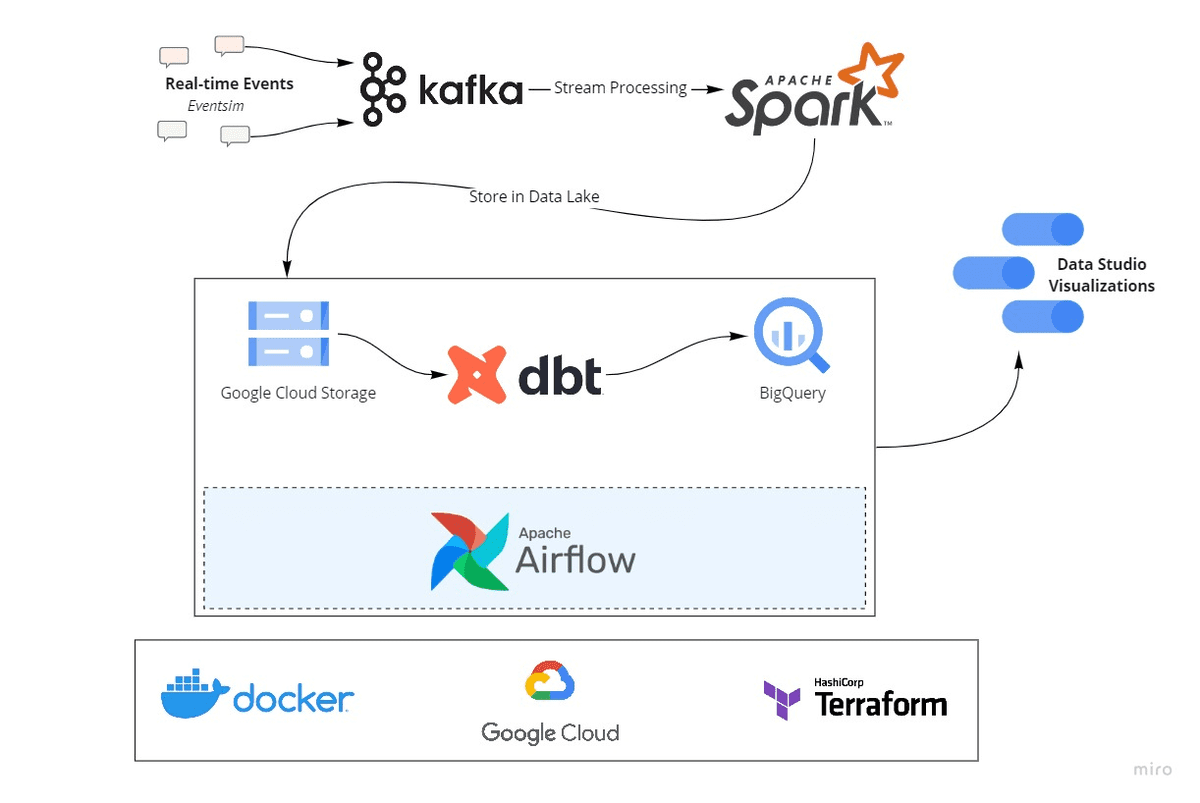

Kafka, Spark Streaming, dbt, Docker, Airflow, Terraform, GCP와 같은 도구를 사용하여 종합적인 데이터 엔지니어링 파이프라인을 구축하는 프로젝트다.

음악 스트리밍 서비스를 시뮬레이션하며 실시간 데이터 스트림을 다뤄보고 이를 효과적으로 처리하고 분석하는 방법을 학습할 수 있다.

이 프로젝트는 스트리밍 데이터의 복잡성과 이를 관리하는 데 사용되는 기술들을 이해하는 데 도움이 된다.

[ Reddit Data Pipeline Engineering ]

- Repository Link -

GitHub - airscholar/RedditDataEngineering: This project provides a comprehensive data pipeline solution to extract, transform, a

This project provides a comprehensive data pipeline solution to extract, transform, and load (ETL) Reddit data into a Redshift data warehouse. The pipeline leverages a combination of tools and serv...

github.com

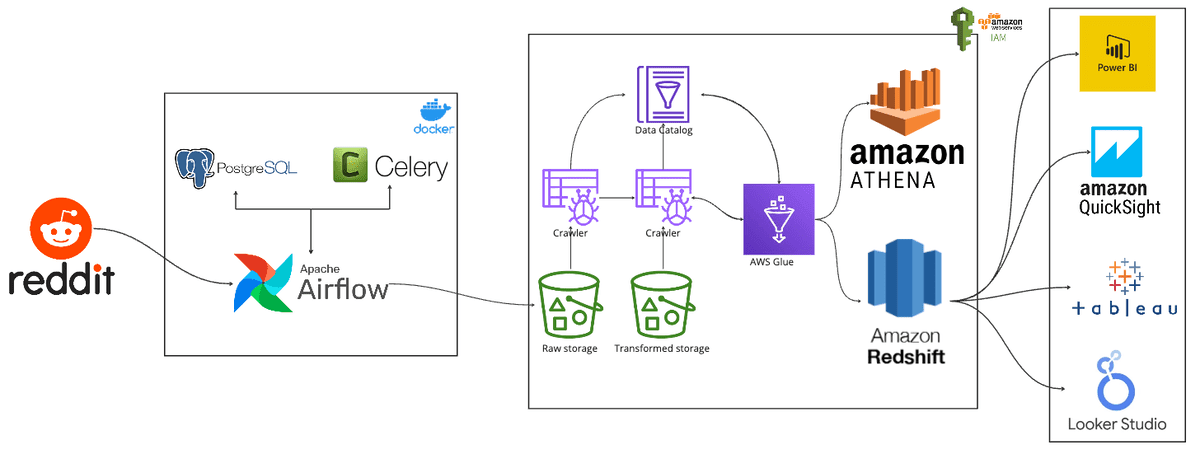

이 프로젝트는 Reddit 데이터를 위한 종합적인 추출, 변환, 적재(ETL) 솔루션을 제공한다.

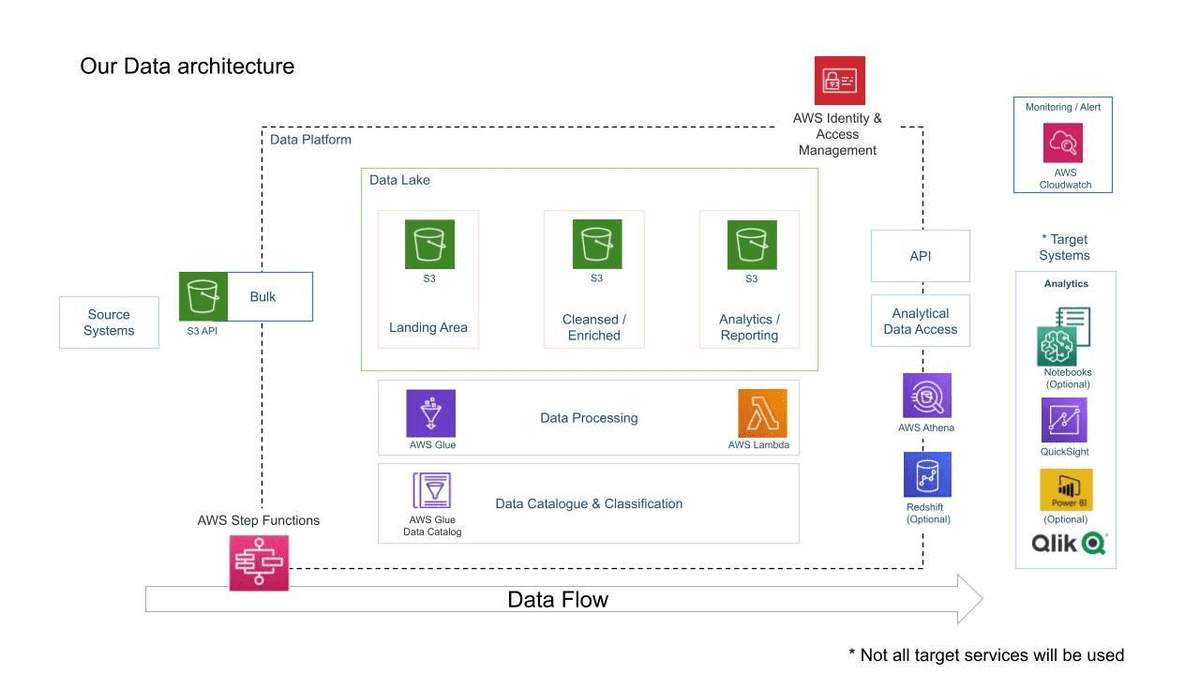

Apache Airflow, Celery, PostgreSQL, Amazon S3, AWS Glue, Amazon Athena, Amazon Redshift를 활용하여 데이터를 추출, 변환하고 Redshift 데이터 웨어하우스로 적재한다.

확장 가능한 데이터 파이프라인을 구축하고 클라우드 환경에서 대규모 데이터를 관리하는 방법을 배우기에 적합하다.

[ GoodReads Data Pipeline ]

- Repository Link -

GitHub - san089/goodreads_etl_pipeline: An end-to-end GoodReads Data Pipeline for Building Data Lake, Data Warehouse and Analyti

An end-to-end GoodReads Data Pipeline for Building Data Lake, Data Warehouse and Analytics Platform. - san089/goodreads_etl_pipeline

github.com

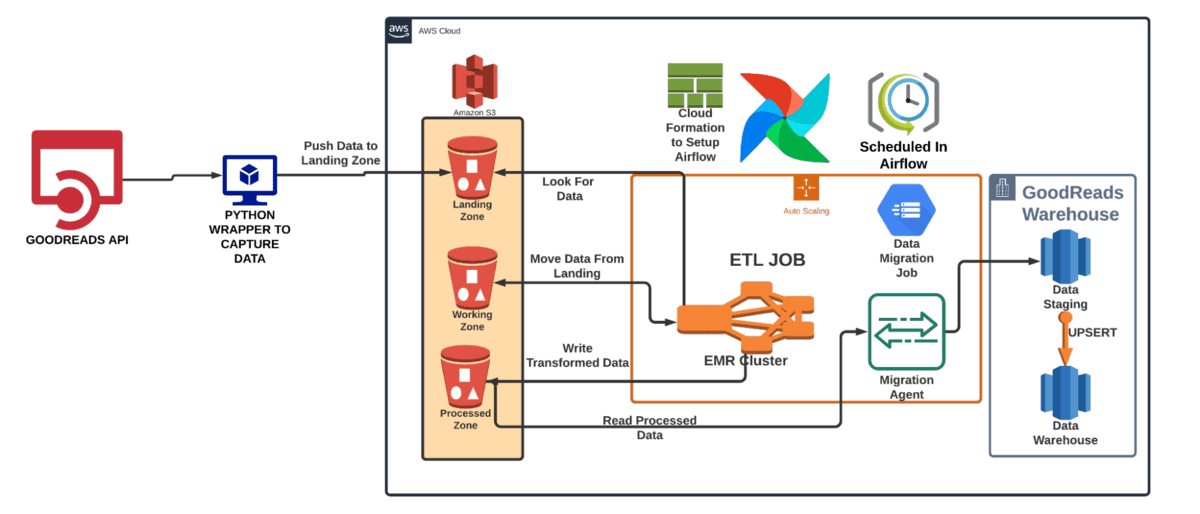

이 프로젝트에서는 데이터 레이크, 데이터 웨어하우스, 분석 플랫폼을 생성한다.

GoodReads Python wrapper를 사용해 GoodReads API에서 데이터를 실시간으로 수집하며, 수집된 데이터는 초기에는 로컬 디스크에 저장된 후 AWS의 S3 버킷으로 전송된다.

Spark로 작성된 ETL 작업은 Airflow를 통해 조율되며 10분 간격으로 실행되도록 스케줄링된다.

이 프로젝트를 통해 다양한 데이터 소스를 다루고 이를 가치 있는 인사이트로 변환하는 경험을 쌓을 수 있다.

[ End-to-end Uber Data engineering project with BigQuery ]

- Repository Link -

GitHub - darshilparmar/uber-etl-pipeline-data-engineering-project

Contribute to darshilparmar/uber-etl-pipeline-data-engineering-project development by creating an account on GitHub.

github.com

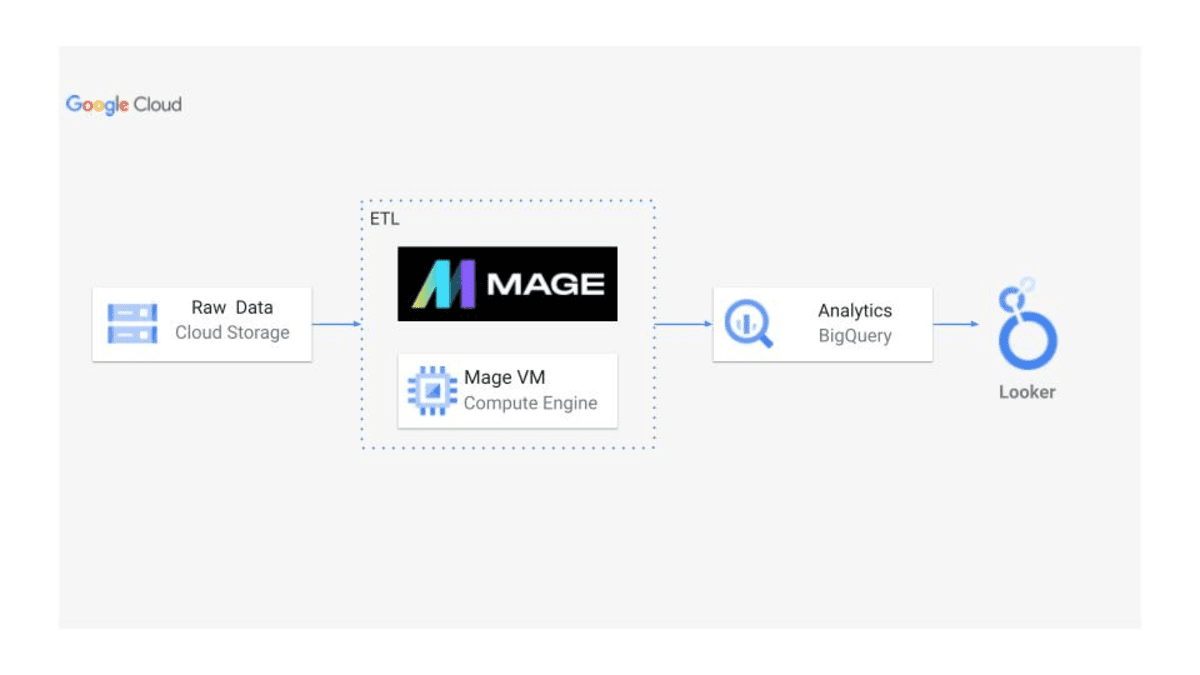

이 프로젝트에서는 BigQuery를 활용하여 Uber 데이터를 위한 종합적인 데이터 엔지니어링 솔루션을 구현한다.

대량의 데이터를 처리하고 분석하는 데이터 파이프라인을 설계하고 구현하는 과정을 포함한다.

클라우드 기반 데이터 웨어하우징 솔루션에 대해 배우고, 성능과 확장성을 최적화하는 데이터 처리 기술을 익힐 수 있다.

[ Data Pipeline for RSS Feed ]

- Repository Link -

GitHub - damklis/DataEngineeringProject: Example end to end data engineering project.

Example end to end data engineering project. Contribute to damklis/DataEngineeringProject development by creating an account on GitHub.

github.com

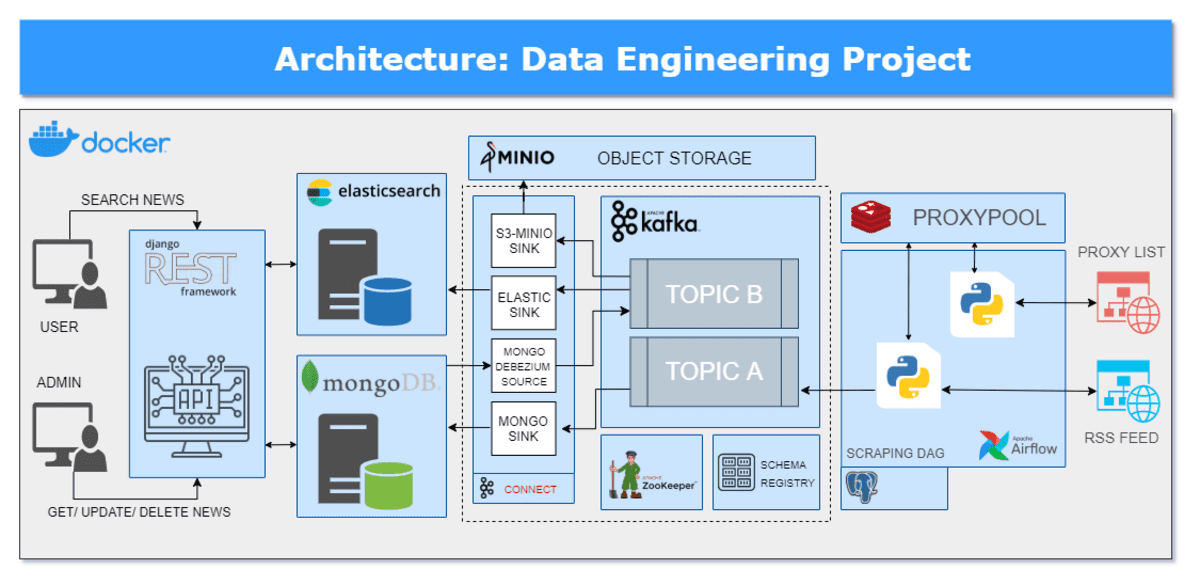

이 프로젝트는 RSS 피드를 처리하기 위한 종합적인 데이터 엔지니어링 솔루션의 예사를 제공한다.

Airflow, Kafka, MongoDB, Elasticsearch를 사용하여 비정형 데이터를 처리하고 데이터 워크플로를 자동화하는 데 필요한 세부 사항을 이해하는 데 유용한 프로젝트이다.

[ YouTube Analysis ]

- Repository Link -

GitHub - darshilparmar/dataengineering-youtube-analysis-project: Data Engineering YouTube Analysis Project by Darshil Parmar

Data Engineering YouTube Analysis Project by Darshil Parmar - darshilparmar/dataengineering-youtube-analysis-project

github.com

YouTube 동영상의 구조화된 데이터와 비정형 데이터를 안전하게 관리, 최적화 및 분석하는 파이프라인을 구축하는 것을 목표로 한다.

이 프로젝트를 통해 대규모 데이터셋을 처리하고, 데이터 변환을 수행하며, 동영상 분석에서 유용한 인사이트를 도출하는 방법을 배울 수 있다.

생각보다 수준이 높은 프로젝트들로 구성되어 있었다.

배울 것이 많겠지만 해당 프로젝트를 실습할 환경을 갖추기는 쉽지 않겠다.

실습할 수 있는 부분은 실습 하고 어려운 부분은 익히기만 하면서 한번 따라가보면 좋겠다.

여기 나온 프로젝트들을 익히게 된다면 그 과정도 블로그로 정리해야겠다.